Generative Künstliche Intelligenz im Trend LAB der DZ BANK

Der breite öffentliche Zugang zu Anwendungen generativer Künstlicher Intelligenz seit Ende 2022, insbesondere durch ChatGPT der US Firma Open AI und zahlreicher sogenannter Bildgeneratoren, hat künstliche Intelligenz erneut in den Fokus der öffentlichen Wahrnehmung gerückt und dies wesentlich stärker als in früheren Jahrzehnten. Erstmals nutzen viele Menschen über diesen Weg bewusst künstliche Intelligenz. Daneben hat eine breite Diskussion zur kommerziellen Nutzung eingesetzt.

Die DZ BANK Gruppe hat daher zusammen mit Mitwirkenden der Atruvia, des BVR und fünf VR-Banken dazu ein Trend LAB durchgeführt. In einer mehrteiligen Reihe wollen wir hier im Blog auf ausgewählte Erkenntnisse dazu eingehen und einen Blick in die gegenwärtige und künftige Nutzung werfen.

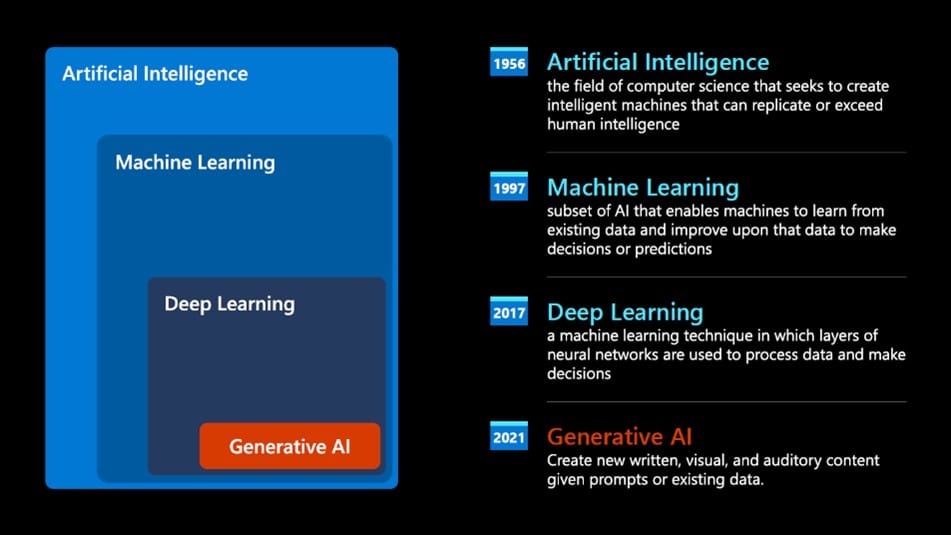

Generative Künstliche Intelligenz (Gen KI) ist ein Teilbereich der Künstlichen Intelligenz (KI). KI bezeichnet nach der Definition des Europaparlaments die Fähigkeit einer Maschine, menschliche Eigenschaften wie logisches Denken, Lernen, Planen sowie Kreativität zu imitieren und ermöglicht es so, ihre Umwelt wahrzunehmen, mit dem Wahrgenommenen umzugehen und Probleme zu lösen, um ein bestimmtes Ziel zu erreichen. Maschinen sollen also menschliche Intelligenz in bestimmten Aufgabengebieten nachahmen oder übertreffen können.

Kategorisierung Künstlicher Intelligenz: (Quelle: Vortrag Microsoft im Trend LAB)

Die Hauptfunktion generativer KI besteht darin, Inhalte zu generieren (1). Die Bezeichnung „generativ“ unterstreicht die inhaltserzeugende Funktion dieser Systeme (2). Die zugrundeliegenden KI-Modelle basieren auf künstlichen neuronalen Netzen, die „von der Funktionsweise biologischer Gehirne inspiriert sind – ihre ´Intelligenz´ steckt in der Verbindung der künstlichen, simulierten Neuronen.“(3)

Als typische Beispiele für generative KI-Systeme gelten Bildgeneratoren (z. B. die Anwendungen Midjourney, Stable Diffusion, Firefly oder Dall-E), große Sprachmodelle (z. B. GPT4, Bard oder Claude), Tools zur Codegenerierung (z. B. MS GitHub Copilot) oder Tools zur Audiogenerierung (z. B. VALL-E oder resemble.ai). Eine große Übersicht weiterer Tools bietet Hugging Face – The AI community building the future.

Hier geht es um das Anwendungsgebiet großer Sprachmodelle (Large Language Models (=LLM)), da diese für Finanzunternehmen die meisten interessanten Anwendungsfälle ermöglichen.

In diesem Zusammenhang ist der Begriff „Foundational Models“ relevant. Hierbei handelt es sich um komplexe Modellarchitekturen, in der Regel mit >100 Mrd. Parametern. Diese werden von kommerziellen Anbietern und auch Universitäten oft auf umfangreichen Datenbeständen und mit enormem Hardwareaufwand trainiert. Sie bilden häufig die Grundlage für generative Modelle. Die Diversität dieser Modelle, d.h. ihre Fähigkeit, zahlreiche textbasierte Aufgaben zu erfüllen, erlaubt vielfältige, in der Breite skalierbare Anwendungsfälle, aber auch die Ableitung zahlreicher spezialisierter Anwendungsfälle. GPT-4 kann sogar mit Texten und Bildern arbeiten, ist also multimodal, was den Möglichkeitsraum nochmals erweitert. Vielseitig einsetzbare, vortrainierte Modelle werden auch als General Purpose Models bezeichnet.

Moderne KI-Modelle, insbesondere Neuronale Netze, arbeiten probabilistisch, erzeugen ihre Ergebnisse also mittels wahrscheinlichkeitstheoretischer Methoden, können diese aber nicht immer stichhaltig begründen. Sprachmodelle zuverlässig auch komplexere Logikaufgaben (Reasoning) oder Berechnungen durchführen zu lassen ist aktuell noch ein Forschungsfeld.

Generative Modelle erzeugen im weitesten Sinne komplexe Inhalte („Content“), also etwas, das über einzelne Buchstaben, Ziffern, Bildpixel etc. hinausgeht. Diese Technologie ist nicht neu (4), die Zugänglichkeit der Technologie über ChatGPT (natürlich-sprachlicher Zugang) und der Wegfall von Sprachbarrieren hat den Trend aber seit November 2022 stark gefördert und in die breite Öffentlichkeit getragen.

Am Markt existieren viele fertige (= vortrainierte) Lösungen, vor allem von US-Unternehmen wie OpenAI, Microsoft, Google, und Meta. Oft machen die Anbieter aber nicht transparent, mit welchen Daten die Modelle trainiert werden und in welchem Umfang Eingabedaten von Nutzenden zu weiteren Trainings verwendet werden. (5)

Vortrainierte Modelle können für Unternehmen individualisiert werden, z.B. über das Einlesen interne Dokumente und entsprechendes „Prompting“. (6) Vortrainierte Modelle können außerdem in eigenen geschützten Umgebungen über API-Aufrufe um unternehmensinterne Daten, Sprachstil und Parameter erweitert werden. Daneben können über API-Aufrufe und Plugins die Ausgabeinformationen um Daten aus externen Quellen ergänzt werden, wie aktuelle Daten zum Kontostand, Markt- oder Umweltdaten, Berechnungen (z.B. über eine Verbindung zu Wolfram Alpha oder die Anbindung an eine interne SQL-fähige Datenbank) oder andere aktuelle Informationen, die über Webseiten bereitgestellt werden. (7) Darüber hinaus besteht die Möglichkeit, Sprachmodelle auf Basis von Open-Source-Modellen vollständig selbst zu trainieren. Neben US-amerikanischen und anderen internationalen Unternehmen bietet das Heidelberger Start-up Aleph Alpha mit Luminous ein großes Sprachmodell an, das besonders zuverlässig komplexe Arbeitsschritte mit hohen Sicherheitsanforderungen unterstützen soll. Die Ergebnisse sollen erklärbar und reproduzierbar sein und sich damit besonders für die Bereiche Recht, Medizin und Finanzen eignen. (8)

Bekommen die Anbieter die Qualitätsprobleme in den Griff?

Als Berta Benz 1894 die erste Fernfahrt mit einem Automobil anstrengte, hatte sie mit erheblichen Qualitätsproblemen zu kämpfen. Es gab viele Zweifel, ob sich Automobile überhaupt durchsetzen würden oder nicht doch bessere Pferdekutschen das Automobil verhindern. Wie bei den meisten Innovationen, müssen Anwender generativer KI mit zum Teil erheblichen Qualitätsproblemen rechnen. Dazu gibt es eine Fülle von Benchmarks und Bewertungen von Sprachmodellen. Bestehende Arbeiten zeigen, dass Sprachmodelle eine angemessene Leistung bei traditionellen Sprachaufgaben wie Leseverstehen, Übersetzung, und Zusammenfassungen zeigen, aber nicht stets zu 100% verlässlichen Aussagen produzieren. In jüngerer Zeit wurde gezeigt, dass GPT-4 auch schwierige, standardisierte Prüfungen in Berufsfeldern wie Medizin und Recht bestehen kann. Allerdings schwankt die Qualität der Ergebnisse in Abhängigkeit von den gestellten Aufgaben.(9) Es ist z.B. besser im deduktiven als im induktiven Schlussfolgern. Außerdem können Halluzinationen erzeugt werden, wenn keine Wissensdatenbank als verlässliche Datenquelle zusätzlich genutzt wird. Immerhin ermöglicht das in ChatGPT integrierte Reinforcement Learning (10) es, durch die menschliche Zusammenarbeit mit dem zugrundeliegenden Sprachmodell, die Leistung von ChatGPT zu verbessern. In Abhängigkeit vom Feedback kann sich dabei natürlich die Leistung auch verschlechtern.

Generative KI lässt zwar generell eine Produktivitätssteigerung bei Arbeitsprozessen erwarten, aufgrund der Qualitätsprobleme gilt dies aber nur unter bestimmten Annahmen, nämlich dann, wenn die Zeitersparnis und der Qualitätsgewinn durch den Einsatz generativer KI größer sind als der Zeitaufwand für die Formulierung der Prompts sowie die Kosten für Qualitätssicherung und Nutzung (inkl. Bereitstellung).

In einem Folgebeitrag schauen wir auf einige Anwendungsfälle im Finanzwesen, die im Trend LAB betrachtet wurden sowie auf ausgewählten Chancen und Risiken.

_____________________________________

Titelbild: Prompt: „Erzeuge ein Bild von Frankfurt in der Zukunft mit fliegenden Autos und einer technischen Umgebung“ (erzeugt mit Bing Image Creator by Dall E)

(1) Dies steht im Gegensatz zu KI-Systemen, die andere Funktionen erfüllen, wie die Klassifizierung von Daten (z. B. die Zuordnung von Etiketten zu Bildern), die Gruppierung von Daten (z. B. die Identifizierung von Kundensegmenten mit ähnlichem Kaufverhalten) oder die Auswahl von Aktionen (z. B. die Steuerung eines autonomen Fahrzeugs).

(2) Helen Toner, What Are Generative AI, Large Language Models, and Foundation Models? Center for Security and Emerging Technology veröffentlich auf cset.georgetown.edu am 12.5.2023 unter https://cset.georgetown.edu/article/what-are-generative-ai-large-language-models-and-foundation-models/ übersetzt mit Unterstützung von deepl

(3) Will Douglas Heaven, Generative KI: Die Geschichte hinter ChatGPT, veröffentlich auf heise.de. am 11.4.2023, abrufbar unter https://www.heise.de/hintergrund/Generative-KI-Die-Geschichte-hinter-ChatGPT-8243968.html

(4) Vgl. Zur Evolution The Practical Guides for Large Language Models, laufend aktualisiert auf Github, abrufbar unter https://github.com/Mooler0410/LLMsPracticalGuide Siehe ergänzend Jingfend Yang et al, Harnessing the Power of LLMs in Practice: A Survey on ChatGPT and Beyond, Working Paper vom 27.4.2023, veröffentlicht auf arxiv.org unter https://arxiv.org/pdf/2304.13712.pdf

(5) Christian Stöcker, Künstliche Intelligenz Maschinen, die geklaute Bücher lesen, Spiegel Online, veröffentlich am 17.7.2023 unter Künstliche Intelligenz: Maschinen, die geklaute Bücher lesen – Christian-Stöcker-Kolumne – DER SPIEGEL

(6) Als Prompt Writing (oder Prompt Engineering) wird der Prozess der Erstellung von Eingaben (in der Regel Text) verstanden, die die generative KI anweisen, die gewünschte Antwort zu erzeugen. Prompting ist damit die Art und Weise, wie wir eine KI auffordern, etwas zu tun. Ein Prompt sollte auf die Art der gewünschten Antwort und auf die Besonderheiten der verwendeten generativen KI zugeschnitten sein.

(7) Vgl. Jo Bager und Andrea Trinkwalder, Bot mit Zusatzkräften – Was ChatGPT-Plug-ins können, C´t Ausgabe 18/2023, S. 128 – 131. Vgl. für ChatGPT eine Übersicht mit Plug-ins auf folgender Seite ChatGPT plugins (openai.com).

(8) Vgl. Handelsblatt vom 20.03.2023 https://www.handelsblatt.com/technik/forschung-innovation/ki-wie-chatgpt-und-sam-altman-ihr-leben-beeinflussen-werden/28957638.html

(9) Vgl. Lingjiao Chen, Matei Zaharia, James Zou, How Is ChatGPT’s Behavior Changing over Time?, Working Paper, veröffentlicht am 18.7.2023 unter 2307.09009.pdf (arxiv.org). Vgl. auch Philipp Schönthaler, Grenzen der Sprach-KI: ChatGPT zwischen Effizienz und Wunschdenken, c’t Magazin, veröffentlicht am 23.3.2023 unter https://www.heise.de/hintergrund/Grenzen-der-Sprach-KI-ChatGPT-zwischen-Effizienz-und-Wunschdenken-7583232.html

(10) Reinforcement Learning ist eine Variante des maschinellen Lernens, bei der ein KI-Modell durch Interaktion mit der Umwelt ein Verhalten erlernt, und so über den Zeitraum der Nutzung sich dauerhaft weiterentwickelt. Bestärkendes Lernen – Wikipedia

Diese Themen interessieren uns

Lean and Secure Decentralized Delivery-versus-Payment (DvP) for Securities Settlement

22. Dezember 2023

FinTech Innovationen in Asien – Ein Blick auf das FinTech Festival in Singapur

3. November 2023